2016年3月、Googleによって開発されたコンピュータ囲碁プログラムAlphaGoが韓国の囲碁棋士イ・セドルとの対決で圧勝しました。かつて、IBMが開発したスーパーコンピュータ「ディープブルー」が1997年に当時最強のチェス選手であるガルリ・カスパロフに勝利しましたが、チェスの難易度は囲碁より遥かに低いため、AlphaGoの勝利は「本格的なAI時代の到来」だと話題になりました。

AIの起源

1955年から1956年の間、AI研究の第一人者とされるDartmouthアカデミーの助教授John McCarthy氏、ハーバード大学のMarvin Minsky氏、IBMのClaude Shannon氏、そしてベル研究所のNathaniel Rochester氏が共同で初めて「人工知能(AI)」の定義を掲げました。

「AIとは、抽象的な事柄や概念を別の言語で表現し、その抽象的概念で人々の抱える問題を解決する、あるいは自発的学習をすることで成長するあらゆる機械のことである」

より簡潔な言葉でまとめるとこうなるでしょう。「人間と同じような行動パターンが備わった機械は、『インテリジェント』と言える」

以降、AIが様々な分野で幅広く活用されてきました。囲碁やゲームの他に、最近では自動運転が挙げられます。アメリカの一部地域では既に自動運転 Level 4 (特定条件下における完全自動運転)の実験を始めており、Level 5 (完全自動運転)に到達する日はそう遠くはないでしょう。車両と歩行者の安全を守るには、法規制の他に、AIアルゴリズム開発者たちの努力も不可欠です。一方、IoT分野では、センサー、スマートフォン、ネット検索、顔/車両ナンバー認証、スマートメーター、マシンビジョン、産業用制御システム…AIはあらゆる分野に活用され、仕事と生活をより便利でスマートにしつつあります(図1)。

(図1:様々な分野で幅広く活用され始めたAI)

急速に拡大するAIサービスの市場規模

IDCの統計(図2)によると、2020年から2021年の間、世界のAIサービスの複合年間成長率(CAGR)は17.4%に達しました。2024年には18.4%に上昇し、時価総額が378億ドルに達する見通しです。その中に、ディープラーニングアーキテクチャ、畳み込みニューラルネットワーク、AI関連の半導体製品(CPU[i]、GPU[ii]、FPGA[iii]、TPU、ASIC[iv])など、カスタムアプリケーションとカスタムプラットフォーム向けのサポートとサービスも含まれています。

(図2:IDCによるAIサービスの市場予測)

同じくIDCの統計によると、全世界で生成・消費されるデジタルデータの総量が2018年の33ZB (ゼタバイト)から、2025年には175ZBに激増し、その中でも50%がIoTデバイスによるデータで占められると予測されています。2025年までに、世界で約140億台のIoTデバイスが設置されると考えた場合、クラウド側における計算能力の拡張に注力することで、急速に増えるデータ量に対処するという発想があります。しかし、これはそう単純な話ではありません。IoTデバイスからクラウドまでのデータ転送におけるバンド幅、遅延等の既存課題を考慮していないからです。これは「エッジコンピューティング」が急速に台頭した理由でもあります。

IoTデバイスの急速な拡大に伴い、ひたすらバンド幅とクラウドサーバー数を増やすことは最適解ではなくなっています。IoTデバイス単体で十分動作するアプリケーションが数多く存在するため、あらゆるデータをわざわざクラウド側で処理するのは非効率だと言えます。ファクトリーオートメーション分野では、データストレージまでの距離が近いほど効率が上がりますし、5Gモバイルデバイスメーカーは端末に搭載されるAIを強化しています。しかし、IoTデバイスの演算-ストレージアーキテクチャを改善しない限り、いずれ深刻なバッテリー寿命問題にぶつかるでしょう。

プライバシーやセキュリティにも注意が必要です。あらゆるものがネットで繋がるこの現代において、機密資料やデータの漏洩、ハッカーの侵入が多発しています。エッジ側で計算を行うことで、クラウドと端末間のデータ転送回数を減らせば、データとネットセキュリティを確保できるだけでなく、消費電力とシステム全体のコスト低減も期待できます。

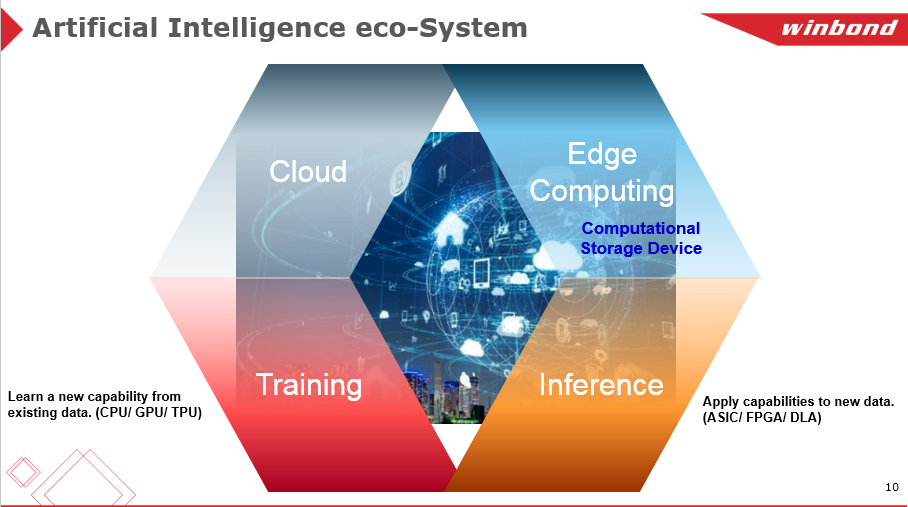

AIチップの比較

AI技術は用途別に、「トレーニング」と「推論」の2種類に大別されます。前者は主にクラウド側でCPU、GPU、TPUが実行し、データベースを拡充することでデータモデルを構築することを目的とします。後者はエッジデバイスや特定のアプリケーションによく用いられ、ASIC、FPGAがトレーニング済みのデータモデルに基づき推論を行います。

前述でも触れたように、AI関連のチップとして、CPU、GPU、FPGA、TPU、ASIC等いくつもの種類があります。計算力(Computing)、ソフトウェアフレキシビリティ(Flexibility)、ハードウェアの互換性(Compatibility)、消費電力(Power)、コスト(Cost)の5つの軸から、上記を大まかに比較しました(図3)。

(図3:AI関連チップの比較)

フォン・ノイマン型アーキテクチャのボトルネックの克服

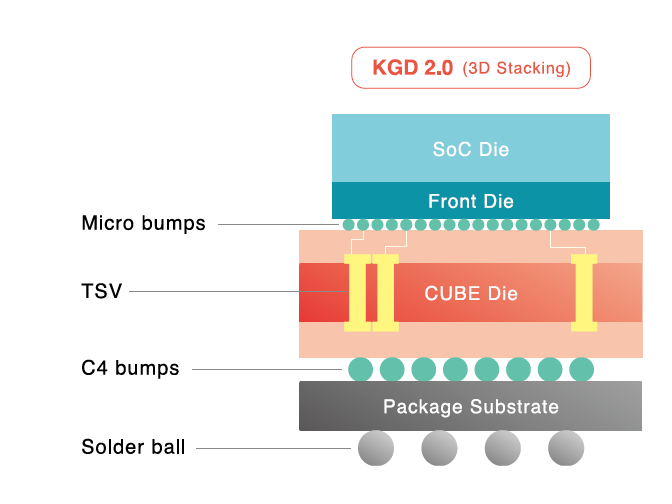

従来のコンピュータに幅広く採用されているフォン・ノイマン型アーキテクチャは、演算と記憶の機能は分離され、演算が重んじられる特徴があります。そのため、データはプロセッサとメモリの間で何度も行き来し、80%の時間と電力消費を費やしてしまいます。この課題を改善するために、様々な方法が提案されました。光インターコネクト、2.5D/3D積層による高バンド幅通信、キャッシュレベルの向上、高密度チップ等によるニアデータ処理で、メモリアクセスに生じる遅延や高い電力消費を抑えようとしました。

しかしよく考えれば、我々人間の脳は、そもそも演算と記憶が分離しているでしょうか?左脳で計算し、右脳で記憶しているのではなく、人間の脳は計算と記憶を共に同じ場所で行うようにできており、データを送受信する必要はないのです。

そこで、脳を模した画期的なアーキテクチャの開発が待ち望まれており、これができれば、演算と記憶が有機的に融合され、記憶装置で計算も行える、あるいは様々な記憶装置に対応するように計算装置を分類し、データ転送による電力消費を最大限抑えるのが一番理想的です。この発想により「計算用ストレージ(Computational Storage Device)」という概念が生まれました。

ストレージ関連の会社が非常に参考になる概念を打ち出しています。不揮発メモリはアナログ-デジタル変換によるアナログ信号を保存するだけでなく、演算も実行可能です。入力電圧と出力電流は不揮発メモリにおいて可変抵抗の役割を果たし、アナログ電流をデジタル信号に変換し、デジタル信号入力-デジタル信号出力というプロセスを完全に実行します。この方法の最大のメリットは、成熟した20/28nm CMOSプロセスで生産でき、CPU/GPUのように7nm/5nmの高コストプロセスが必要ないことです。コストと消費電力の低減とともに、遅延も大幅に改善されます。これはドローン、AIロボット、自動運転、監視カメラ等にとって非常に重要な特性です。

総じて言えば、端末の推論プロセスの演算が比較的シンプルで、定型的なタスクが多く、ハードウェアの加速機能の汎用性への要求が高くない、アーキテクチャを頻繁に変える必要がないシチュエーションがよりストレージ内演算に向いています。関連データによると、2017年までAIのトレーニングと推論は、ほとんどクラウド側で行われましたが、2023年になると、エッジデバイス・チップでAI推論を行う仕組みが市場シェアの半分以上を占めるようになり、取扱額が200~300億ドルに達するとのことです。これはICメーカーにとって大変魅力的な市場規模です。

AIにはどんなフラッシュメモリが必要か

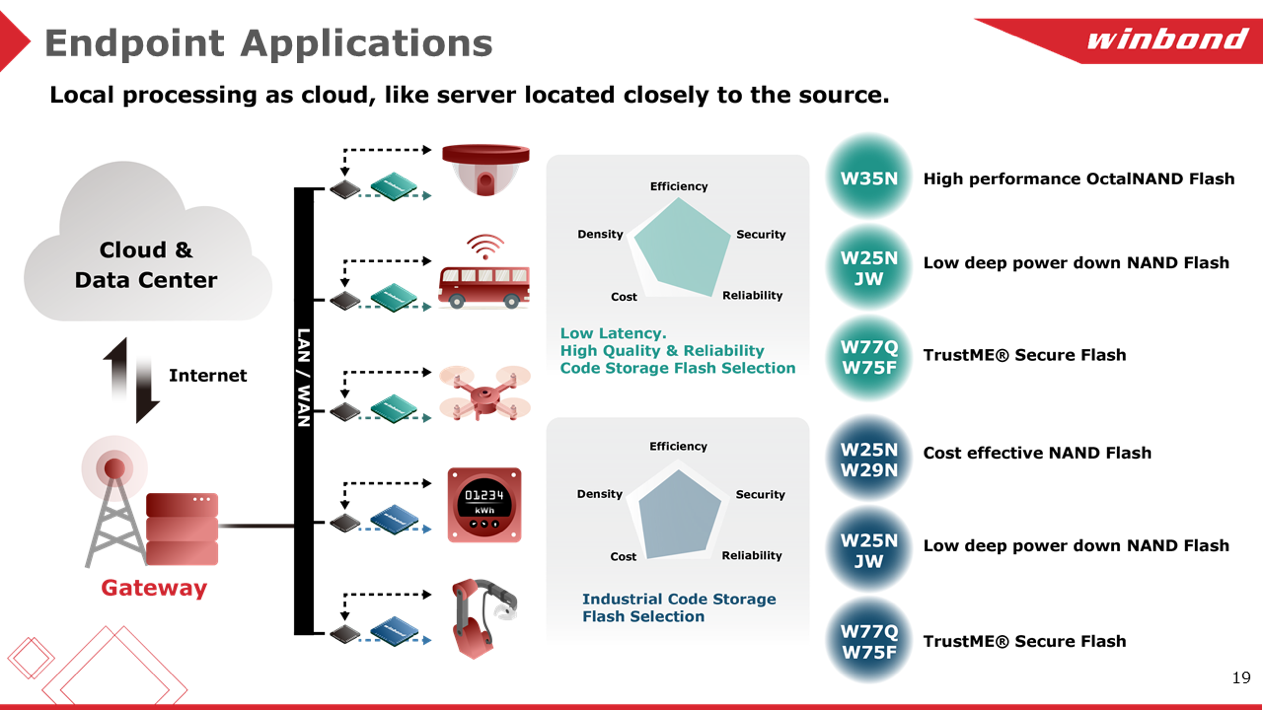

AIチップにとって、高品質・高信頼性・低遅延のフラッシュメモリの重要性は言うまでもありません。しかし、アプリケーションによって性能・消費電力・セキュリティ・信頼性・機能等を総合的に考慮する必要があります。また、コストはもちろん大事ですが、コストを優先するあまり、他の要素を疎かにすることはできないとウィンボンドは考えます。

高性能OctalNANDフラッシュW35Nシリーズ、低消費電力アプリケーション向けQspiNANDフラッシュW25N-JWシリーズ、セキュリティ用途向けTrustME(R)W77Q/W75Fシリーズは、ウィンボンドの主力商品です。QspiNANDフラッシュのデータ転送速度は最大83MB/秒であるのに対し、OctalNANDフラッシュは最大240MB/秒で、前者の約3倍に当たります。車載アプリケーションに対しては、125℃ Automotive Grade 1に対応したシリアルNORフラッシュと115℃ Automotive Grade 2+に対応したSLC NAND/QspiNANDフラッシュをラインナップしています。スマートセンサーまたは生産ライン用ロボットに関して、ウィンボンドはコストと高性能を両立したソリューションを提供できます。

(図4:ウィンボンドのフラッシュメモリ・ソリューション)

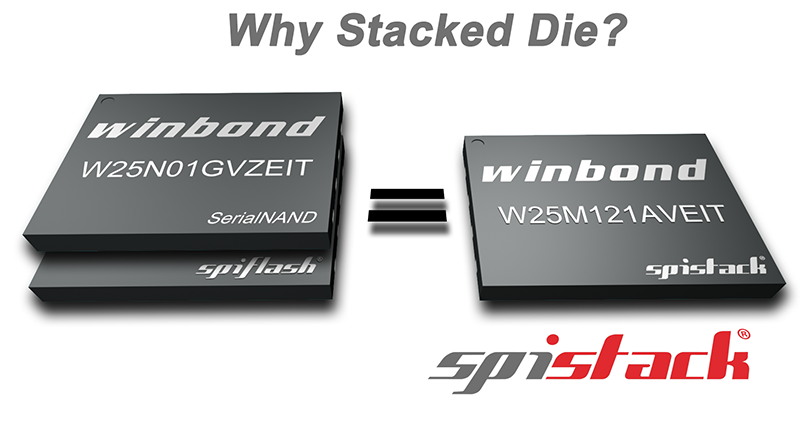

豊富なフラッシュメモリのラインナップのほかに、SpiStack(NOR+NAND)も特筆すべき製品です。例えば、64MビットのシリアルNORフラッシュと1GビットのQspiNANDフラッシュをワンパッケージにスタックし納めることで、コードをNORに保存すると同時に、NANDにも保存できるようになります。また、2チップ(NOR+NAND)スタックであるものの、SpiStackの制御に必要な信号端子数はわずか6つです。

(図5:ウィンボンドのSpiStack(NOR+NAND)

ウィンボンドは最適なフラッシュ製品をご提案することで、お客様が開発した大切なコードをお守りします。各製品の詳細については、https://www.winbond.comの製品ページをご参照ください。

[i] CPU

発展の歴史が長く、演算力も高い。ソフト・ハードフェアの互換性が抜群。しかし、フォン・ノイマン型アーキテクチャの特性上、データがメモリとプロセッサの間を繰り返し行き来する仕組みにより処理の平均速度が抑えられ、消費電力とコストパフォーメンスも他のチップと比べて優位性が少なく、中ぐらいのレベルにある。

[ii] GPU

NvidiaのGPUを例に挙げると、「Compute Unified Device Architecture」を採用し、コア数が多いため、メモリを自在に読取れるのみならず、シェアードバーチャルメモリで処理をさらに加速させることができる。フォン・ノイマン型アーキテクチャの制約を受けるが、平均計算力はCPUの数十倍から千倍以上になる。GPUにも比較的長い歴史があるため、ソフト・ハードウェアの互換性に優れるが、消費電力とコストパフォーマンスには改善の余地がある。また、クーリングシステムの追加など、ハードウェアの追加投資が必要になることがある。

[iii] FPGA

長年の発展を経て、互換性に優れている。演算力、コスト、消費電力は最高レベルではないが、折衷案としての過不足はない。開発者にとって、AIチップ開発の入門として最適。

[iv] ASIC

特定のアプリケーションのために開発された専用品で、テストをした上で調整を行えば、計算力、消費電力、コストが最高レベルに達することができる。